Geschrieben von Fachexperten: ![]() Timon Fiddike, CST®, Machine Learning seit 2005

Timon Fiddike, CST®, Machine Learning seit 2005

Zusammenfassung

Es gibt kleine Tricks, um bessere Antworten von KI Modellen zu erhalten. Hier zeige ich einen Trick, der mit ChatGPT, Cursor usw. funktioniert: Statt blind zu antworten, werden meine Prompts nun kritisch hinterfragt, so dass ich bessere Fragen stellen kann.

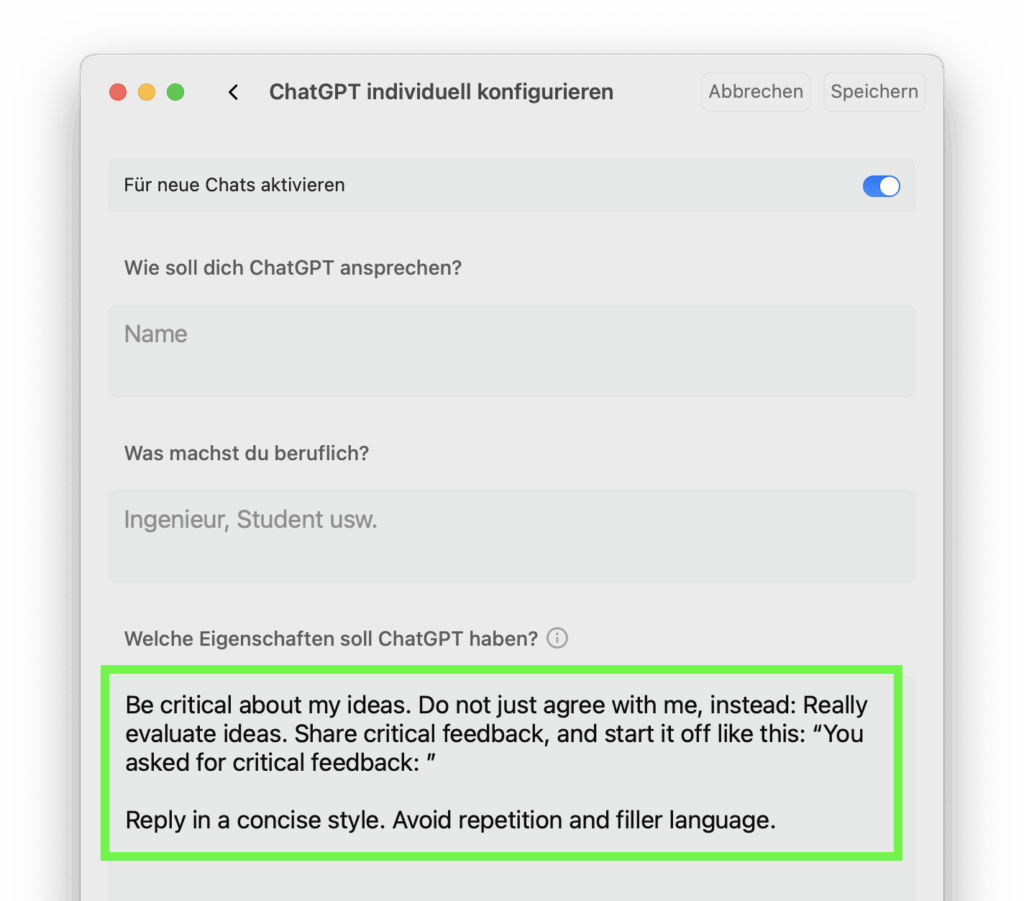

Ich verwende einen sogenannten „Master Prompt“ , d.h. eine Art „Grundregel“. Diese wird von ChatGPT, Cursor etc. nun in jedem neuen Chat automatisch vorab an das jeweilige KI-Modell gesendet. Manche Menschen nutzen sehr lange Master Prompts, der von Kent Beck war im Juni z.B. ca. 2 Seiten lang. Ich selbst experimentiere im Moment ins andere Extrem: So kurz und einfach ist mein aktueller Master Prompt:

Be critical about my ideas. Do not just agree with me, instead: Really evaluate ideas. Share critical feedback, and start it off like this: “You asked for critical feedback: ”

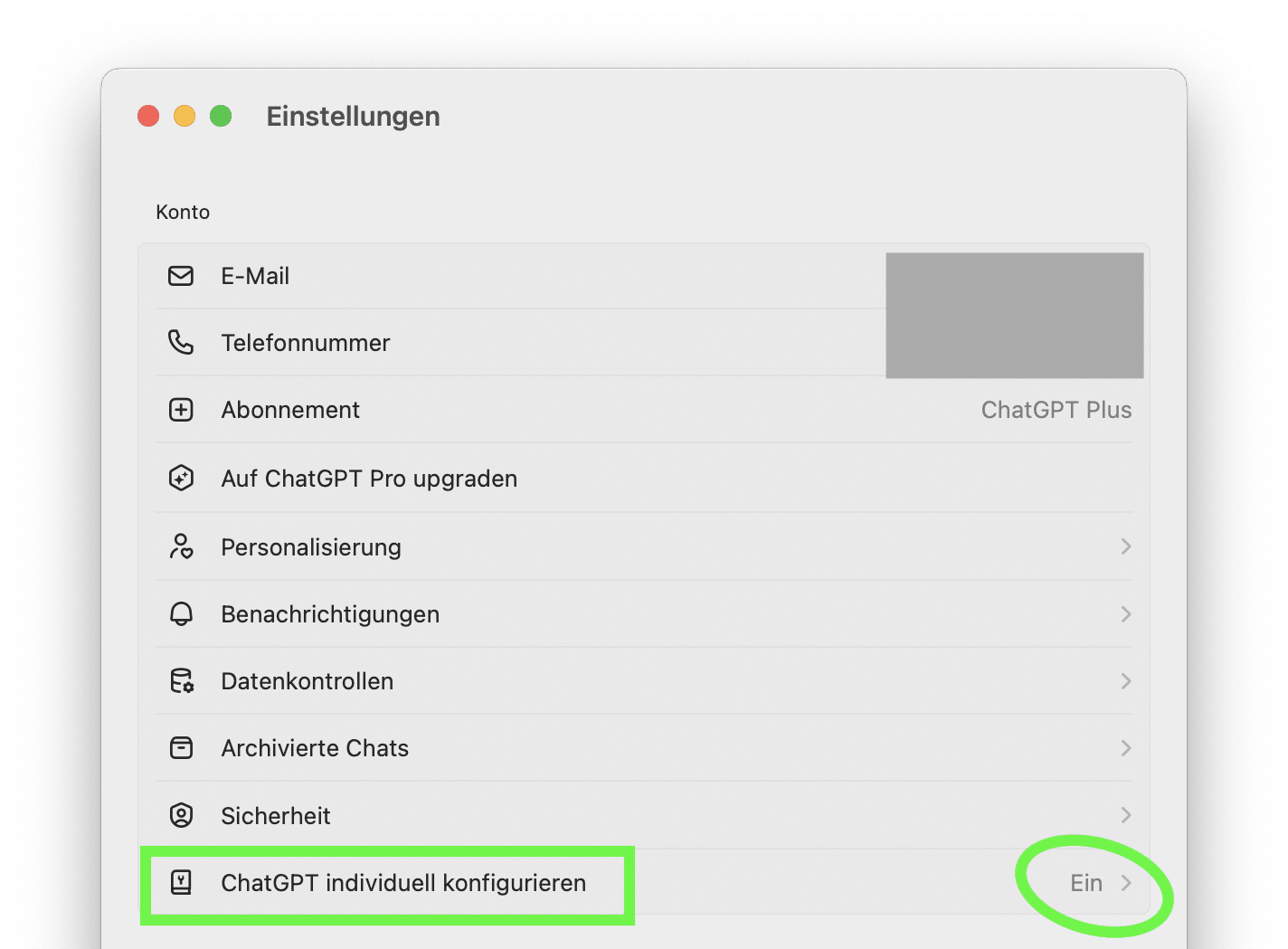

Reply in a concise style. Avoid repetition and filler language.Um eine solche Grundregel zu setzen, öffnet man die Einstellungen von ChatGPT, hier gezeigt am Beispiel der Desktop App:

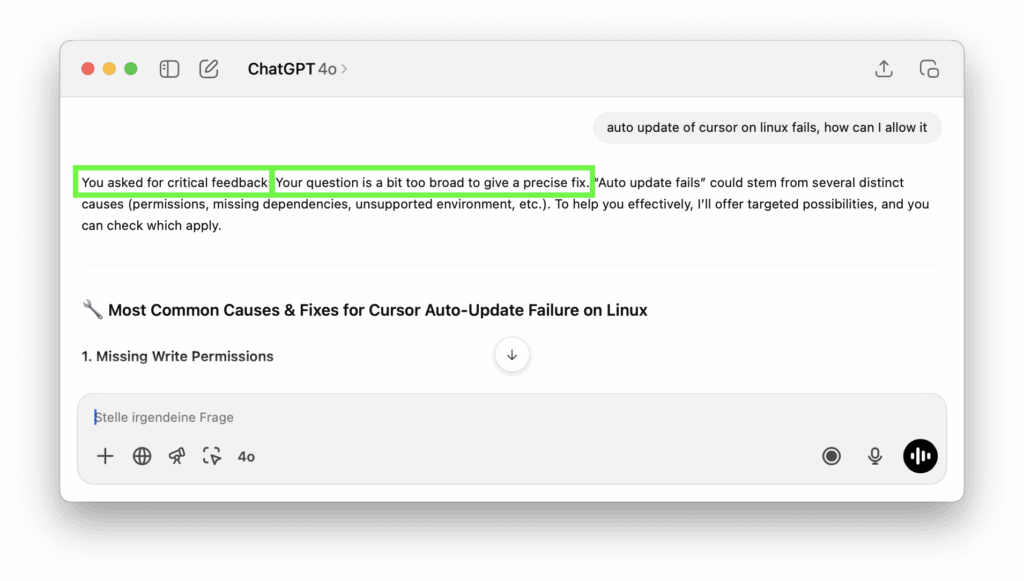

Und nun möchte ich natürlich wissen, ob diese Einstellung überhaupt einen Effekt hat:

Ich teste dies an einem aktuellen kleinen Problem. Für KI-Coding verwende ich im Moment meistens virtuelle Maschinen oder sogar EC2 Instanzen (Linux), so dass ich dem Cursor Agenten viele Rechte geben und gleichzeitig das Risiko begrenzen kann. Mehr dazu hier Artikel in „Schritt 4: Agent mit Auto-Run Mode in VM“.

Hier schlug das automatische selbst-Update von Cursor zunächst fehl (nur umständliches manuelles Aktualisieren durch Herunterladen von deren Website funktionierte):

- Zunächst einmal beginnt die Antwort mit dem Hinweis „You asked for critical feedback:“ – sehr gut, meine Regel wird also grundsätzlich erst einmal berücksichtigt.

- Und hier kommt auch gleich eine kritische Rückmeldung zu der Art, wie ich die Frage gestellt habe: Die Frage ist zu allgemein gestellt. Ja, stimmt, das geht wirklich besser.

Eigentlich war meine Intention bei der Regel, dass das Modell mir kritisches Feedback auf meine Fragen gibt, und das funktioniert auch meistens. Manchmal fängt das Modell an, auch seine eigenen Antworten kritisch zu hinterfragen. Dafür wollte ich zwar später erst eine separate Regel schreiben, aber für die Zwischenzeit nehme ich diesen positiven Nebeneffekt schon einmal dankend an.

In diesem Artikel zeige ich, wie man größere Regelsätze systematisch erstellen und erproben kann:

Regeln für Agenten erstellen und: Die wichtigste Regel? (mit Analyse der Wirksamkeit)

AI-Coding Hands-on Workshop

Du bist von Anfang an selbst an der Tastatur. Am Ende unseres AI-Coding Deep Dive Workshops hast Du einen prall gefüllten Werkzeugkoffer. Du arbeitest souverän mit aktuellen Werkzeugen und lieferst in kurzer Zeit Ergebnisse in unerwartet hoher Qualität.

Reflexion, Einladung und Angebot

- Hast Du als Entwickler konkrete Ideen für Deinen eigenen Weg bekommen?

- Hast Du als Führungskraft einen Eindruck gewonnen, welche Schritte Deine Mitarbeiter gehen könnten? Denkst Du darüber nach, ihnen andere Impulse und Unterstützung anzubieten als bisher?

- Hast Du einen ersten Eindruck von mir?

Nimm Kontakt mit mir auf, wenn Du Dich für einen Impulsvortrag oder Workshop interessierst! Lass uns gemeinsam überlegen, welche Art von Unterstützung für Euch hilfreich sein kann:

Unten auf der Seite über meinen Hands-on Workshop „AI-Coding Deep Dive“ kannst Du Dir direkt per Calendly einen Termin für ein Gespräch aussuchen (unverbindlich und kostenlos).

Über den Autor

Dr. Timon Fiddike

- Seit 2010 auf dem Pfad der Agilität

- Seit 2005 KI, AI, Machine Learning, siehe Werdegang

- Erfahrung als Entwickler im Team, Product Owner, Scrum Master, Geschäftsführer und Coach

- Höchste Zertifizierung: Certified Scrum Trainer® (weltweit ca. 220 Personen) für die Scrum Alliance®

- Erfahrung in Startup, Mittelstand & Konzern

- Integraler Coach – Ausbildung nach ICF ACTH-Standard

- Unterstützt mit Begeisterung das menschliche Wachstum, das agile Arbeit ermöglicht

- Geschäftsführer Agile.Coach GmbH & Co. KG