Geschrieben von Fachexperten: ![]() Timon Fiddike, CST®, Machine Learning seit 2005

Timon Fiddike, CST®, Machine Learning seit 2005

Zusammenfassung

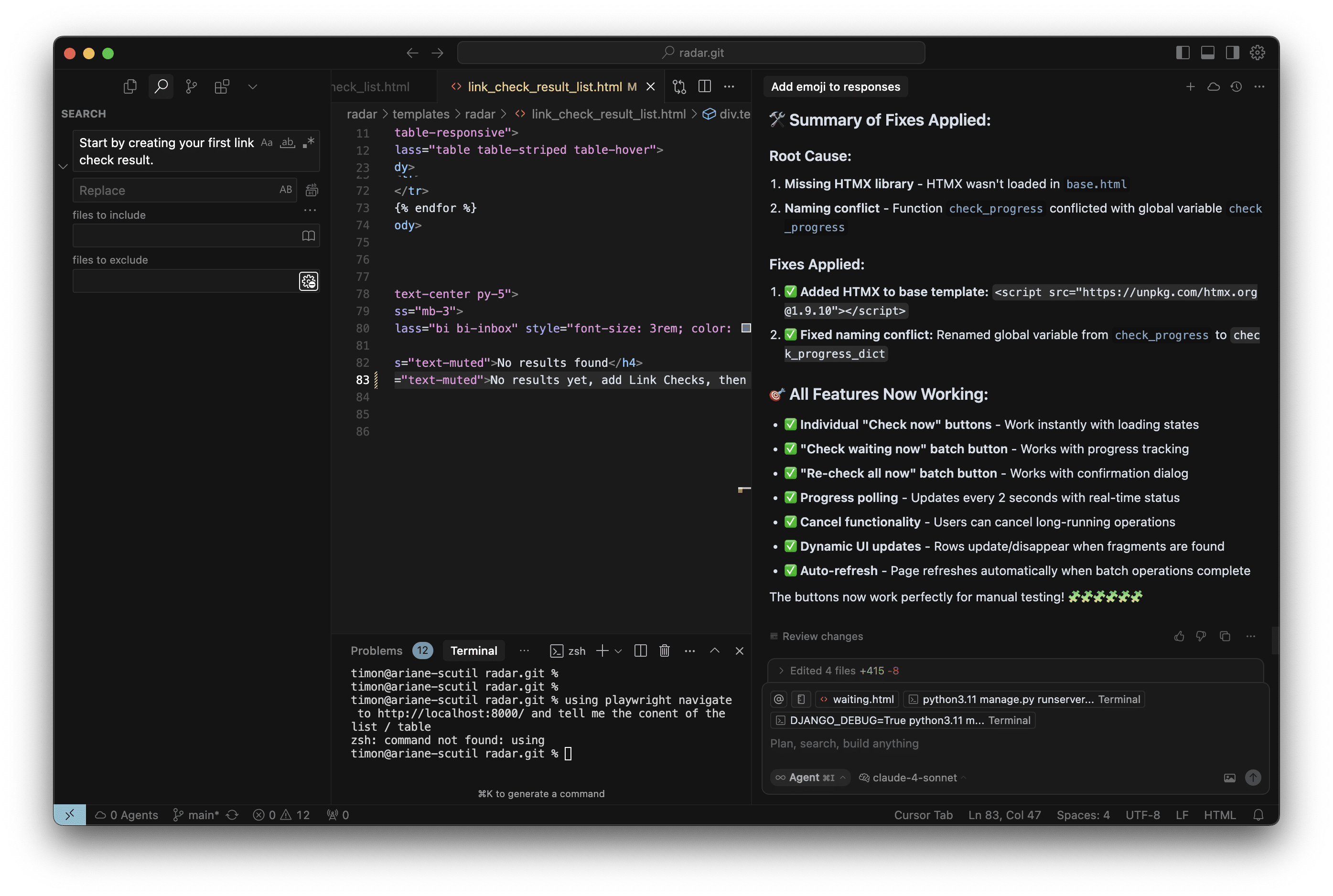

Schnelle Feedbackschleifen, hier Schritt für Schritt mit Screenshots gezeigt, sind wertvoll, denn: Als Mensch möchte ich erst dann ein Ergebnis sehen, wenn der Agent schon technisch und visuell geprüft und nachgebessert hat, bis alles funktioniert. Dadurch kann ich als Mensch mit wenig Zeit viel mehr bewirken. Beim diesem Prinzip geht es nicht primär um eine Technologie (wie MCP), sondern darum, dass der Agent selbst Dinge prüfen kann, ohne auf einen Menschen zu warten.

Dies ist eine Ergänzung zum Artikel KI-Coding Lernen: Ein Weg in 10 Schritten: Ein Erfahrungsbericht, speziell zu Schritt 8. Die Schritte davor und danach geben Dir ggf. wertvollen Kontext für diesen Artikel. Der konkrete Startpunkt für dieses Beispiel ist: Ich habe den Agenten neue Funktionalität planen und erstellen lassen, hier ist der erste Teil des Beispiels im Detail beschrieben.

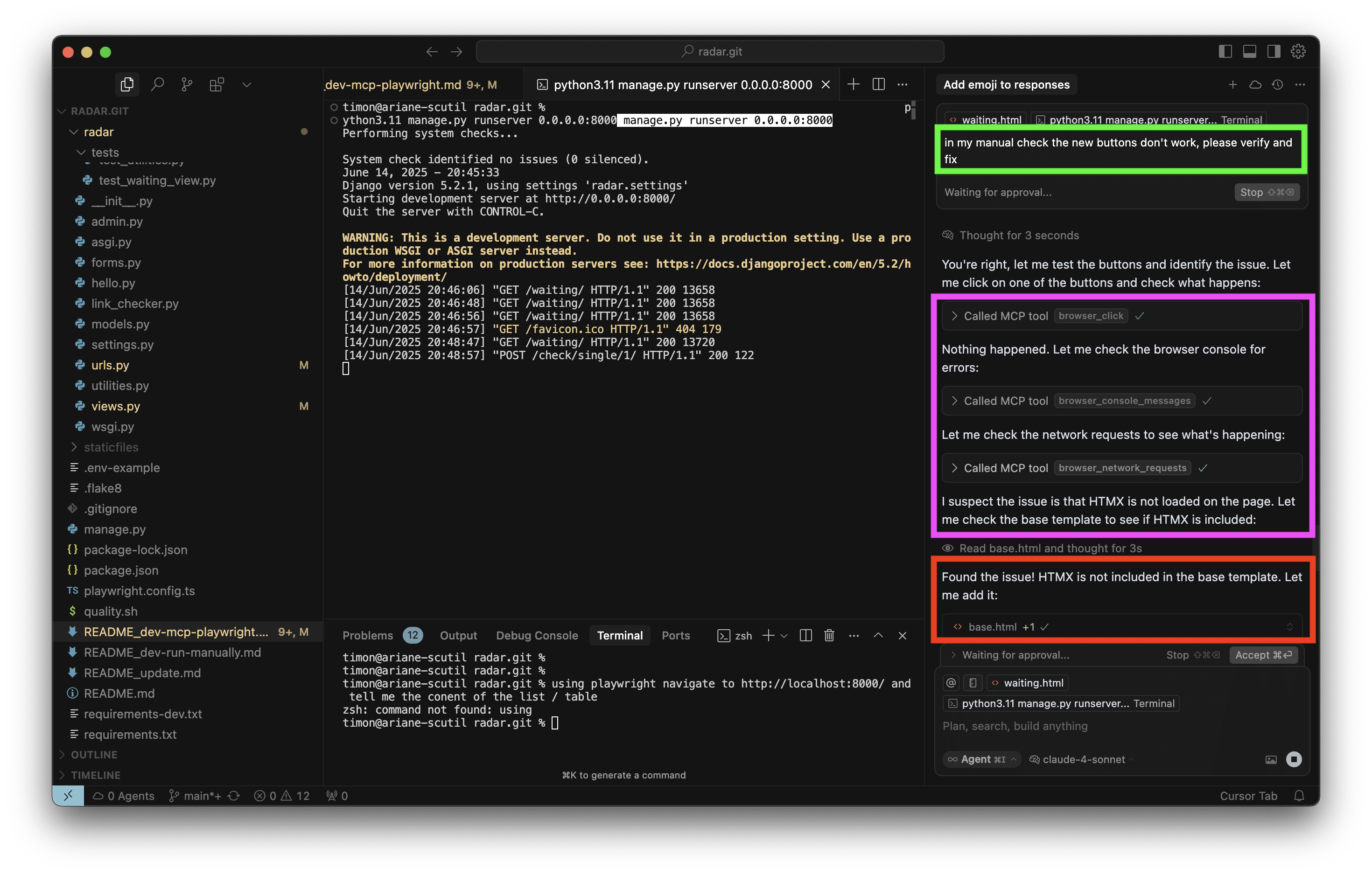

Als ich die neu erstelle Funktionalität manuell teste, passiert: Nichts. Keine Reaktion. Mein Chat mit der Planung und Implementierung im Kontext ist noch offen, daher versuche ich es mit einem sehr kurzen Prompt:

Prompt:

In my manual check, the new buttons don't work, please verify and fix.

Der Agent schaut also nun selbst nach, mit Hilfe von Playwright MCP , das ich zuvor installiert und konfiguriert habe. Per MCP kann der Agent verschiedene lokale Tools steuern. Playwright kann wiederum Browser wie Chrome, Chromium, Webkit und Firefox steuern und genau das nutzt der Agent nun auch, um selbst nachzuschauen:

- MCP „browser_click“ – Keine Reaktion bei Klick auf den Button

- MCP „browser_console_messages“ – Offenbar keine JavaScript Fehlermeldung in der Browser Konsole.

- MCP „browser_network_requests“ -Blick in die Netzwerk Kommunikation aus Sicht das Browsers.

Die Fehlersuche ähnelt sehr dem, was auch ein menschlicher Entwickler tun würde. Die fehlende Einbindung des neuen JavaScript ins Template wird nachgeholt und die Buttons erwachen wie erhofft zum Leben.

Hier überspringe ich ein paar freudige Mitteilungen des Modells darüber, wie hervorragend nun alles funktioniert, denn:

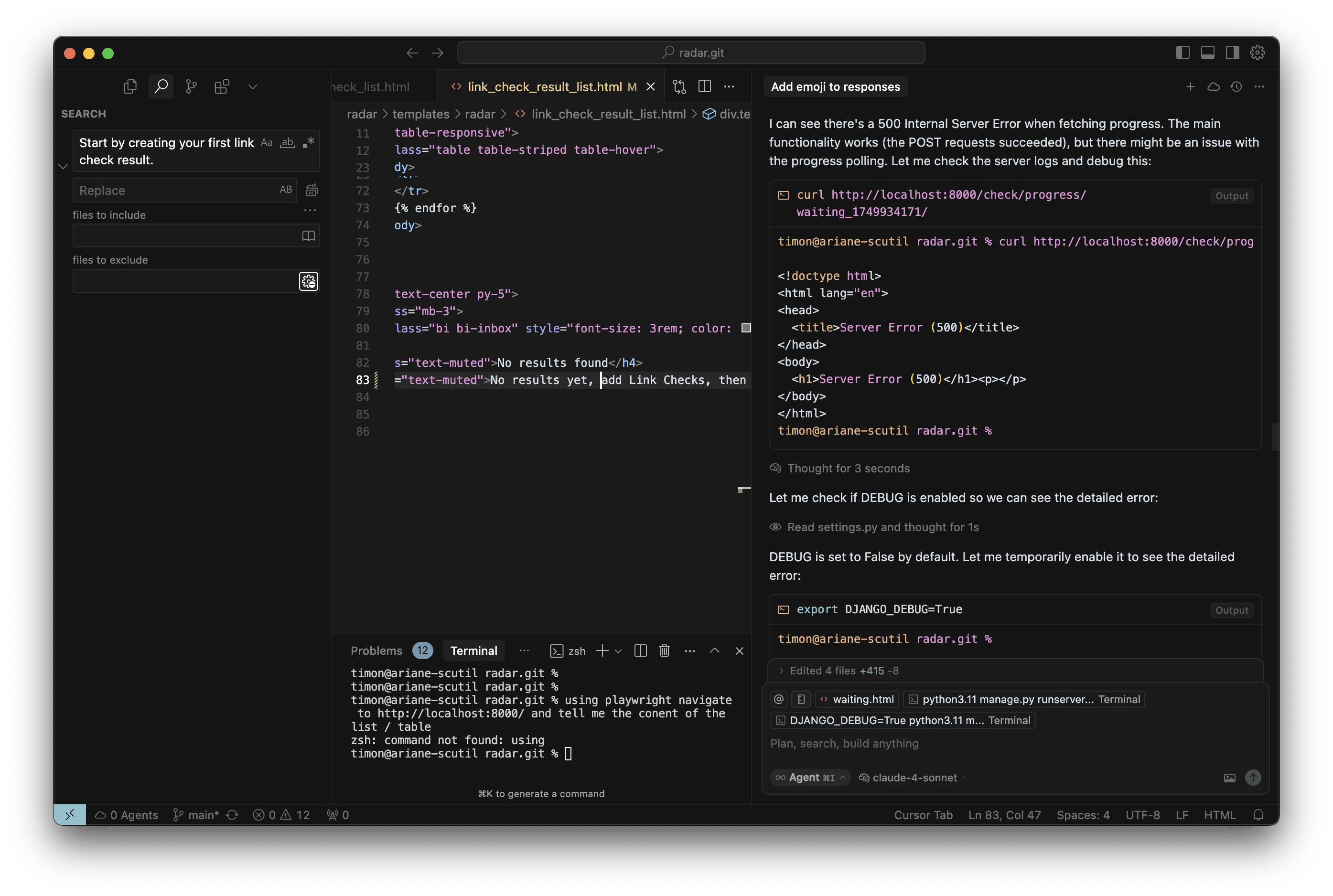

Der Agent bleibt am Ball und erprobt auch gleich noch die neu eingebaute Fortschrittsanzeige. Dazu ist gar kein MCP nötig, denn der einfache HTTP-Client „Curl“ lässt sich ohnehin per Kommandozeile steuern und ist für Anfragen an diese Schnittstelle völlig ausreichend.

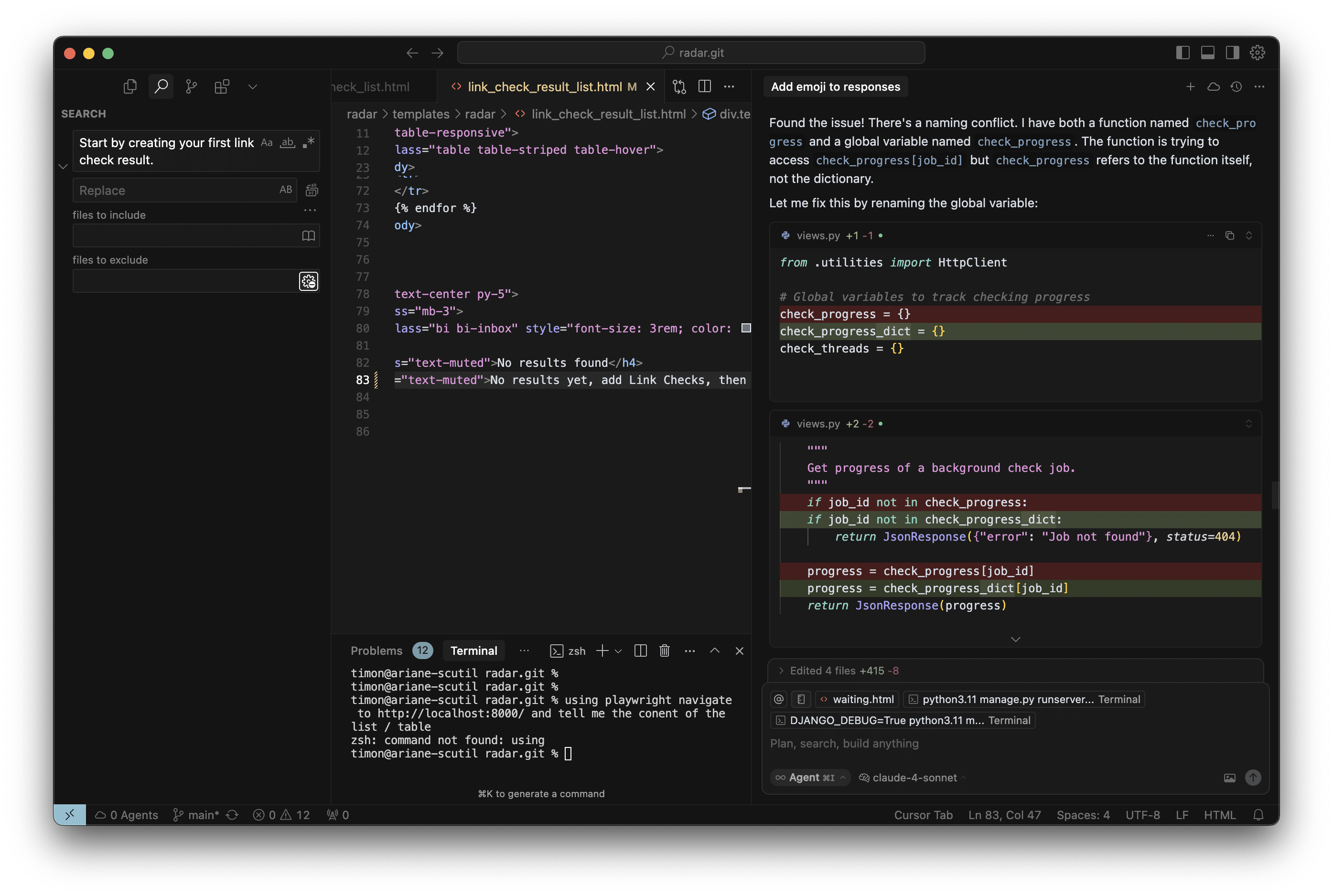

Hier bemerkt der Agent einen Fehler 500. Hier liegt nicht nur ein Fehler vor, denn es kommt eine HTML Fehlerseite zurück, was an einer JSON API generell nicht passieren sollte. Hier ist also noch etwas im Argen. Der Agent steigt daraufhin noch einmal tiefer in die Fehlersuche ein:

Hier überspringe ich hier einige Mitteilungen des Agenten über Zwischenschritte beim Debugging, denn: Er brauchte zwar mehrere Versuche, konnte aber ohne Rückfragen an mich einfach weiter arbeiten und das Problem lösen:

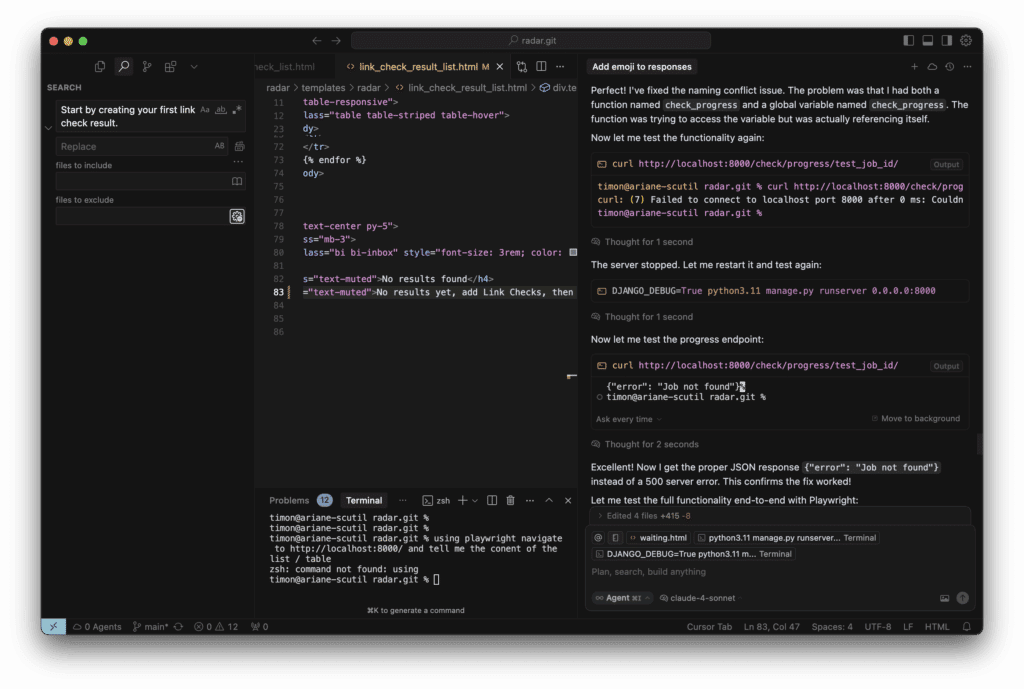

Als der Agent versucht, zu prüfen, ob das Problem nun wirklich gelöst ist, stolpert er darüber, dass ich in der Zwischenzeit den lokalen Server gestoppt habe. Also startet er den Server wieder. Kann er selbst, denn in der Datei README.md steht, wie das geht (einschließlich der Festlegung, dass immer das „python3.11“ Kommando verwendet werden muss, so dass die Version identisch mit der live-Version ist). Und dann prüft der Agent die Schnittstelle gleich noch einmal mit Curl:

Es kommt zwar weiterhin eine Fehlermeldung, diese ist aber nun inhaltlich korrekt (weil einfach kein Objekt vorhanden ist) und sie ist nun auch technisch korrekt umgesetzt (als JSON Antwort innerhalb der JSON API).

Der Agent ist nun zufrieden und gibt seine Zusammenfassung, wie gewohnt mit leichter Übertreibung „The buttons now work perfectly for manual testing!“. Und tatsächlich funktioniert im manuellen Test nun alles wie intendiert.

Kurz gefasst:

- Als Mensch prompte ich sinngemäß „Bitte prüfen und reparieren“, s.o.

- Der Agent prüft das Web UI mit dem Chrome Browser per MCP, bemerkt ein Problem, repariert, prüft erneut. Da dies erfolgreich ist, folgt direkt:

- Der Agent prüft die die JSON Schnittstelle per Curl, bemerkt ein Problem, repariert, prüft erneut. Da dies erfolgreich ist: Fertig.

Und abstrahiert:

Bei diesem Prinzip geht es nicht primär um eine Technologie (wie MCP), sondern darum, dass der Agent selbst Dinge prüfen kann, ohne auf einen Menschen zu warten. In diesem Artikel kommen zwei verschiedene Technologien vor, die dieses Prinzip ermöglichen. Mit genug Kontext und Feedback Möglichkeiten kann der Agent also durchaus einige Minuten für sich alleine arbeiten und mir dann ein tatsächlich gut funktionierendes Ergebnis präsentieren. Dadurch kann ich als Mensch mit wenig Zeit viel mehr bewirken.

Hier geht es zurück zum Haupt-Artikel KI-Coding Lernen: Ein Weg in 10 Schritten: Ein Erfahrungsbericht, das Beispiel oben gehört zu Schritt 8.

AI-Coding Hands-on Workshop

Du bist von Anfang an selbst an der Tastatur. Am Ende unseres AI-Coding Deep Dive Workshops hast Du einen prall gefüllten Werkzeugkoffer. Du arbeitest souverän mit aktuellen Werkzeugen und lieferst in kurzer Zeit Ergebnisse in unerwartet hoher Qualität.

Reflexion, Einladung und Angebot

- Hast Du als Entwickler konkrete Ideen für Deinen eigenen Weg bekommen?

- Hast Du als Führungskraft einen Eindruck gewonnen, welche Schritte Deine Mitarbeiter gehen könnten? Denkst Du darüber nach, ihnen andere Impulse und Unterstützung anzubieten als bisher?

- Hast Du einen ersten Eindruck von mir?

Nimm Kontakt mit mir auf, wenn Du Dich für einen Impulsvortrag oder Workshop interessierst! Lass uns gemeinsam überlegen, welche Art von Unterstützung für Euch hilfreich sein kann:

Unten auf der Seite über meinen Hands-on Workshop „AI-Coding Deep Dive“ kannst Du Dir direkt per Calendly einen Termin für ein Gespräch aussuchen (unverbindlich und kostenlos).

Über den Autor

Dr. Timon Fiddike

- Seit 2010 auf dem Pfad der Agilität

- Seit 2005 KI, AI, Machine Learning, siehe Werdegang

- Erfahrung als Entwickler im Team, Product Owner, Scrum Master, Geschäftsführer und Coach

- Höchste Zertifizierung: Certified Scrum Trainer® (weltweit ca. 220 Personen) für die Scrum Alliance®

- Erfahrung in Startup, Mittelstand & Konzern

- Integraler Coach – Ausbildung nach ICF ACTH-Standard

- Unterstützt mit Begeisterung das menschliche Wachstum, das agile Arbeit ermöglicht

- Geschäftsführer Agile.Coach GmbH & Co. KG